Catastrofe Climatica: paranoia collettiva o scienza rigorosa?

Un articolo a quattro mani scritto da Alberto De Luigi e Giacomo Zucco.

Murales a Bristol che ritrae Greta Thunberg. Si tratta ormai di un soggetto ricorrente nella street art, si veda ad esempio la gigantografia su un palazzo nei pressi di Union Square, San Francisco

Indice:

- Introduzione

- Il consenso scientifico

- Fondamenti della teoria del riscaldamento antropogenico

- Ipotesi incerte, non teorie verificate

- Una metodologia dubbia e criteri scientifici laschi

- La Chaos Theory applicata al clima: il battito d’ali di farfalla che scatena un uragano

- Assunzioni controverse a fondamento di una “soft science”

- Teorie mai predittive

- Stime volubili e mai verificate

- Variabili e parametri inaffidabili

- Distorsione ideologiche

- Il caso Climategate: assessment scientifici o di convenienza politica?

- Modelli econometrici, dietologia e altre “soft science” per politicanti

- Il grande pianificatore centrale

- Conclusione

Le emissioni di gas dovute ad attività umane producono un aumento di temperatura e questo effetto si può definire come “aumento della temperatura di origine antropica”. Elementi come vapore acqueo e CO2, infatti, trattengono il calore generato dal sole, che dopo aver raggiunto il pianeta viene disperso nello spazio extraterrestre più lentamente.

Nonostante una certa abitudine a travisare i contenuti del cosiddetto “negazionismo” sul tema, in realtà quasi nessuno contesta l’esistenza di questo fenomeno [eccetto: vedi]. Quello che manca è semmai un ampio consenso sulla quantificazione della sua portata nel contesto più ampio delle interazioni tra uomo e clima. Le stime spaziano infatti da effetti infinitesimali ed addirittura impercettibili per la maggior parte degli esseri viventi, fino a scenari addirittura catastrofici.

Poiché dare una risposta rigorosa a tale quesito richiede uno studio della materia non alla portata di tutti, il dibattito pubblico si risolve sovente con l’argomento ab auctoritate che richiama un presunto consenso scientifico: “quasi tutti gli scienziati concordano sul fatto che…”.

Da un punto di vista epistemologico, la nozione di “consenso scientifico” non è a sua volta un concetto scientifico, se con questo termine intendiamo richiamare l’accezione comune definita, da Karl Popper in poi, a partire dal criterio di riproducibilità e falsificabilità. Tuttavia, anche volendo usare tale espressione per intendere una valutazione sociologica della frequenza e della confidenza con cui una certa affermazione viene ripetuta dalla maggioranza di coloro che sono ritenuti i principali esperti di un determinato campo specialistico, possiamo comunque affermare che non c’è attualmente “consenso scientifico” relativamente al fatto che ci sia un aumento anomalo della temperatura per cause antropogeniche.

Per lo più, gli scienziati impegnati sul tema mantengono prudenzialmente una posizione agnostica, ovvero sono possibilisti sul fatto che l’uomo sia fra le cause di un anomalo riscaldamento globale in atto, ma riconoscono che non ci sia alcuna evidenza scientifica in merito. Questo contrariamente a quanto si sente spesso raccontare dai media generalisti e ripetere nel contesto della propaganda politica.

Trentuno mila (31.000) scienziati, ricercatori e accademici Statunitensi, nel corso degli ultimi due decenni, hanno firmato per una campagna contro il catastrofismo che si chiama “Global Warming Petition Project”. Per ognuno degli oltre trentamila è possibile leggere nome, cognome, titolo accademico e campo di studio sul sito: petitionproject.org Il testo firmato riporta:

“Non c’è un’evidenza scientifica convincente che le emissioni antropogeniche di CO2, metano o altri gas serra stia causando o causerà, nel futuro prevedibile, un riscaldamento catastrofico dell’atmosfera terrestre e la rottura degli equilibri climatici della Terra”.[1]

Nel paper allegato alla petizione[2]:

“Non ci sono dati sperimentali a supporto dell’ipotesi che un aumento dell’uso di idrocarburi o di CO2 e altri gas serra stia causando o causerà cambiamenti sfavorevoli nelle temperature” (p.12)

“La temperatura della terra è controllata da fenomeni naturali” (p. 8)

Un’iniziativa simile è stata lanciata di recente anche in Europa, insieme ad una conferenza stampa[3] e una lettera al Segretario generale dell’ONU[4]: “There is no climate emergency”, con 500 firmatari, per lo più dal mondo accademico. Lo stesso tema è stato ripreso il 18 ottobre a Oslo alla conferenza “Natural Variability and Tolerance”. Il testo e i firmatari della petizione si possono trovare qui.

In passato sono stati sollevati dei dubbi in merito l’autenticità delle firme dietro al Global Warming Petition Project, perciò val la pena approfondire nel merito. La petizione è stata lanciata nel 1997 e nel 2001 erano circa 17 mila i firmatari, di cui solo 1400 che dichiaravano di avere un Ph.D. in scienze atmosferiche, dell’ambiente o della terra. Ad oggi, i firmatari con almeno un bachelor degree in quel campo di studio sono quasi 4 mila (3,805). Per fare una verifica sulla validità della petizione, nel 2001 Scientific American selezionò un campione casuale di 30 persone sui 1400 con Ph.D in queste discipline. Su 26 che sono stati identificati, solo 20 hanno risposto alla richiesta di contatto. Di questi, 6 hanno affermato che ad oggi non avrebbero più firmato quella petizione, mentre 3 hanno affermato di non ricordare alcuna petizione. Gli altri 11 hanno invece confermato il loro supporto. Sulla base di questo campione, per quanto piccolo, si potrebbe pensare che le adesioni effettive alla campagna possano essere meno di quanto dichiarato, ciononostante i numeri rimangono sufficientemente elevati da mettere in dubbio le pretese di scientificità dei cosiddetti “catastrofisti”. Nello stesso periodo in cui Scientific American verificava il campione selezionato, altri critici evidenziavano una mancanza di metodo nella raccolta firme, insistendo sulla presenza di nomi inventati e/o background scientifici non verificati. Da allora gli organizzatori hanno rivisto la metodologia e non è più possibile firmare la petizione online, ma soltanto tramite una lettera postale.

Nel corso del nuovo secolo, la raccolta firme ha quasi raddoppiato i numeri, passando da 17 mila a 31 mila accademici nelle discipline qui elencate. Di ognuno si conosce nome, cognome, titolo accademico e Stato USA di provenienza:

- Atmosphere, Earth, & Environment (3,805)

- Computers & Math (935)

- Physics & Aerospace (5,812)

- Chemistry (4,822)

- Biochemistry, Biology, & Agriculture (2,965)

- Medicine (3,046)

- General Engineering & General Science (10,102)

A fronte di questi numeri, perché allora si sente spesso parlare, su giornali e social, di consenso scientifico acclarato in merito alla teoria del global warming di origine antropogenica? Questa convinzione deriva in particolare da una famosa ricerca effettuata su quasi 12 mila papers accademici che trattano, direttamente o indirettamente, il tema del clima. Il paper è “Quantifying the consensus on anthropogenic global warming in the scientific literature” che si può leggere qui.

Nella conclusione di questa ricerca si afferma che il 97% dei papers analizzati abbraccia la teoria del riscaldamento globale antropogenico. La ricerca sembrerebbe anche dare ad intendere che si tratta di paper sul clima, come recita l’introduzione: “examining 11.944 climate abstracts”.

Per vederci chiaro, abbiamo studiato attentamente questa ricerca al fine di capire a fondo l’affidabilità e la coerenza delle conclusioni. Fortunatamente tutti i dati grezzi sono disponibili online, perciò li riportiamo anche noi qui, insieme alle nostre considerazioni.

Gli 11.944 paper sono stati selezionati utilizzando le keyword ‘global warming’ e ‘global climate change’ dal seguente sito internet, un famoso indicizzatore di paper scientifici: clarivate.com/webofsciencegroup/

Dodici persone si sono spartite i quasi 12 mila papers e ne hanno letto l’abstract, ovvero il riassunto di copertina. Sulla base di quanto scritto nell’abstract hanno classificato il paper come favorevole, contrario o privo di posizione in merito alla teoria del riscaldamento globale (AGW: Anthropogenic Global Warming).

I papers privi di posizione sono circa 8 mila, quindi due terzi. I rimanenti sono stati classificati dal team come 3896 favorevoli alla teoria AGW e 78 contrari. Tuttavia, come affermano gli stessi autori di “Quantifying the consensus”, i papers che “esplicitamente affermano che gli esseri umani sono la primaria causa del recente riscaldamento globale” sono soltanto 64, di cui 20 facenti parti la categoria “mitigation” (che come vedremo, non sono affatto tutti papers di climatologia, ad esempio “Climate Policy Architectures For The Post-kyoto World” è un paper riguardante le policies istituzionali).

Esclusi questi 64, abbiamo voluto dare un’occhiata agli altri 3800 papers circa (estraendone un campione casuale), per constatare che effettivamente fossero studi nell’ambito della climatologia riguardanti il contributo umano nel riscaldamento globale.

Dunque, dai 3896 papers considerati “favorevoli” alla teoria AGW, abbiamo estratto 84 papers, circa il 2% del totale, uno per categoria, per ognuno dei 21 anni analizzati dalla ricerca. Le categorie sono 4:

- Mitigation: 1892 papers

- Impacts: 1223 papers

- Methods: 552 papers

- Paleoclimate: 165 papers

I risultati della nostra analisi lasciano assolutamente stupefatti poiché sembrano indurre conclusioni molto lontane rispetto a quanto lasciato intendere dagli autori della ricerca.

Pittura allegorica che ritrae la titanica lotta fra i due noti modelli di consenso alla base della nostra società: il consenso ScientifiKoh sulla sinistra, e il consenso DemoCratikoh sulla destra

Anzitutto, meno della metà dei papers sono di climatologia: due terzi della categoria “mitigation” (la più popolata), un terzo dei papers della categoria “impacts” e metà della categoria methods sono ricerche in campi molto diversi e per niente attinenti le scienze climatologiche, ad es. ingegneria, economia, politiche pubbliche. I numeri del nostro campione proiettati sul totale ci suggeriscono che sono circa 1800 soltanto i papers che riguardano lo studio scientifico del clima. Questo però non vuol dire affatto che ci siano 1800 papers che spiegano come l’attività umana contribuisca significativamente ad un anomalo riscaldamento globale, al contrario: della categoria più popolata (mitigation) non abbiamo trovato un solo paper che discuta del legame fra CO2 e riscaldamento. Della seconda categoria più popolata (impacts), si parla di possibili conseguenze di una temperatura più alta, che è assunta come postulato di partenza, e mai del legame fra CO2 e temperatura, che semmai è dato per scontato, non discusso. Essenzialmente, sono soltanto metà dei papers della categoria Methods (250 circa) e quasi tutti quelli della categoria Paleoclimate (150 circa) a presentare, almeno in parte, delle discussioni vere e proprie su CO2 e temperatura, o comunque ad analizzare, rivedere e correggere dei modelli climatici che presentano questo legame.

È vero che la maggioranza dei 3892 papers non neghi l’AGW e anzi che in moltissimi casi questa ipotesi sia data per scontata, ma nulla può farci presumere che questa presa di posizione sia dovuta a studi ed opinioni qualificate sull’argomento, quantomeno non più di una firma posta sulla dichiarazione del Petition Project. Infatti, per tirare le somme, possiamo dire che sui quasi 12 mila papers originari, 64 affermano espressamente che l’uomo è la causa primaria del riscaldamento globale, circa 400[5] presentano o discutono modelli climatici in cui vi è una relazione fra CO2 e temperatura, mentre 78 sono contrari alla tesi AGW. Un quadro molto lontano da quello presentato nell’introduzione e conclusione del paper “Quantifying the consensus”.

Per approfondire il nostro studio e vedere di persona il campione di papers che abbiamo analizzato, si legga qui l’appendice (che abbiamo separato dal corpo dell’articolo), dove compare la nostra analisi approfondita, corredata con molti esempi, nonché il campione estratto su cui abbiamo lavorato.

Fondamenti della teoria del riscaldamento antropogenico

Nel caso in cui vi sia consenso su una certa materia, risulterebbe naturale aspettarsi di trovare dei principi condivisi che siano chiari ed esposti in modo sistematico. Tuttavia, se si approfondisce la questione del clima, è estremamente difficile trovare risposte chiare al problema dell’AGW, come quelle che si ottengono per esempio per teorie assodate nel campo della fisica, dell’informatica o di altre scienze. Quindi per farci un’idea qualificata su questo tema, ovvero per capire davvero le meccaniche per cui l’uomo avrebbe un ruolo fondamentale nei mutamenti climatici, abbiamo cercato a lungo nella letteratura al fine di trovare quali siano le ricerche e i paper fondativi della teoria AGW.

In quasi tutti i papers che abbiamo letto, i modelli e le previsioni che vengono citati come riferimento provengono dai documenti dell’IPCC (Intergovernmental Panel on Climate Change) e pochi altri istituti. Fra questi ad esempio, il Canadian Centre for Climate Modelling and Analysis, che ha sviluppato negli anni un modello (Canadian Earth System Model) arrivato oggi alla quarta generazione: CGCM4 (Coupled Global Climate Model 4). Altre istituzioni note che hanno stilato dei “compendi” che riassumono una serie di ricerche sul clima sono lo U.S. Global Research Program, il World Climate Research Programme (WCRP) e il programma ACIA sull’Artico. Istituzioni note e intergovernative come l’IPCC sono generalmente considerate degne di fiducia dai media e dal mondo della politica e delle istituzioni, perciò hanno contribuito fortemente al formarsi di un certo tipo di opinione pubblica in merito al clima. Abbiamo quindi indagato su quali siano le fonti e le ricerche di questi istituti.

Ipotesi incerte, non teorie verificate

Riassunto figurativo dei più noti compendi sul clima, che condensa in 5 parole ogni teoria scientifica in tutte le sue più stratificate declinazioni

Partendo dal U.S. Global Change Research Program, possiamo leggere il relativamente recente Fourth National Climate Assessment (2017/2018)[6]. Questo “assessment” è obbligatorio per legge sin dal 1990, come previsto dal Global Change Research Act dello stesso anno. Il capitolo 3 “Detection and Attribution of Climate Change” riporta il seguente “key finding”, ovvero la scoperta “chiave”:

“Il contributo umano all’aumento medio di temperatura globale nel periodo 1951-2010 ammonta a un probabile range di 0.6-0.8 gradi calorici (alta confidenza). […] È estremamente probabile che oltre la metà dell’aumento medio di temperatura dal 1951 sia causato da influenza umana (alta confidenza).”

A una prima lettura lo statement non è chiarissimo, ma fortunatamente il documento fornisce un dizionario con le definizioni di “probabile”, “estremamente probabile” e “alta confidenza”. Probabile si riferisce a una probabilità superiore al 66%, estremamente probabile sopra al 95%, mentre Alta confidenza significa: “evidenza moderata (alcune fonti coerenti, vari metodi e/o documentazione limitata), medio consenso”. Invitiamo a rileggere la dichiarazione alla luce di queste definizioni.

Insomma, secondo l’assessment del programma di ricerca statunitense, vi è una certa probabilità che l’uomo abbia influito sul clima e su ciò vi è medio consenso e alcune fonti coerenti fra loro. Quando poi si tratta di fare proiezioni sul futuro (vedi il capitolo 4) ogni “key finding” presentato ha confidenza media (medium confidence), che significa, sempre secondo gli autori del compendio: “Poche fonti, limitata coerenza, modelli incompleti, metodi emergenti, scuole di pensiero contrastanti”.

Una metodologia dubbia e criteri scientifici laschi

Il motivo dell’incertezza che traspare da questi “key findings” è presto chiarito quando si comprende la metodologia utilizzata dai climatologi per stimare il ruolo della CO2 nella temperatura della terra, che a grandi linee si può riassumere in questo modo: si costruisce un modello matematico in cui ogni variabile (CO2, cicli dell’acqua, vapore acqueo, nuvolosità etc.) ha un certo peso nel determinare la temperatura. Quindi si applica il modello al periodo storico dove ogni variabile è stata misurata. Se il modello ricalca bene, con una certa approssimazione, la temperatura effettivamente misurata (o stimata) per quel periodo, allora è considerato corretto. Se non è corretto, si provano a cambiare i coefficienti di impatto di ogni variabile (ad es. la CO2 impatta sulla temperatura al 37% anziché al 30%) e si riapplica il modello. Oppure, si escludono alcune variabili precedentemente incluse, o se ne introducono di nuove. Insomma non vi sono meccaniche deterministiche che derivano da esperimenti fisici o chimici di laboratorio, i coefficienti di impatto di ogni variabile sul modello sono adattati secondo un’unica logica: aggiustare il grafico in output affinché combaci con quello delle misurazioni effettive della temperatura. Sebbene un simile metodo di adeguamento ex post dei modelli possa certamente essere condotto in modo rigoroso e rivelarsi utile in molti campi, non è condizione sufficiente affinché si parli di metodo scientifico in senso stretto, il quale dovrebbe portare a previsioni falsificabili su fenomeni ripetibili.

Il grado di confidenza di questi modelli è molto basso: ci sono variabili incluse nei modelli per le quali ancora si dibatte se l’effetto netto sulla temperatura sia effettivamente positivo oppure negativo[7], ad esempio la nuvolosità: le nuvole più alte in cielo impediscono al sole di scaldare la terra, quindi hanno un effetto netto rinfrescante, mentre quelle basse filtrano i raggi solari, ma al contempo trattengono il calore nell’aria, quindi hanno un effetto netto riscaldante. L’effetto netto sulla temperatura calcolato dai modelli climatologici è positivo e pesato per il 40%, ovvero le nuvole sembrerebbero riscaldare più della CO2 (37%). Tuttavia, sappiamo pochissimo sulle nuvole, non riusciamo a prevedere quali tipi di nuvole si formeranno e come quindi influenzeranno il clima in futuro. Un aumento di temperatura dovuto ad altri fattori provocherà una maggiore nuvolosità? E quali tipi di nuvole si formeranno in conseguenza di ciò?

Ciò che riporta lo U.S. Global Change Research Program è semplicemente che, aggiungendo la variabile CO2 ai modelli e pesandola con un certo coefficiente, il grafico in output di questi modelli matematici ricalca meglio la temperatura realmente misurata rispetto allo stesso modello senza la variabile CO2 (la quale sarebbe cresciuta sensibilmente a causa delle attività umane). Per farla breve: il riscaldamento antropogenico è soltanto un’ipotesi per giustificare modelli sui dati passati, e non una teoria scientifica che abbia superato test importanti relativamente a predizioni sul futuro che siano falsificabili.

La Chaos Theory applicata al clima: il battito d’ali di farfalla che scatena un uragano

In foto, l’outcome finale di un modello caotico non-lineare deterministico sul clima: gente in piazza contro le multinaZZionali del petroLLio!

Il padre della teoria del riscaldamento antropogenico è Jule Gregory Charney, un metereologo che nel 1979 raccolse una serie di ricercatori al Woods Hole Oceanographic Institution in Massachusetts per scrivere un report sulla CO2 (“Carbone Dioxide and Climate: A Scientific Assessment”), che fu inviato alla Casa Bianca per avvertire i politici di un possibile disastro climatico.

Nel mondo accademico, secondo i detrattori[8] il report di Charney si basa su correlazioni spurie, vi è persino un paper parodistico che “dimostra” un’elevatissima correlazione fra tasso di omicidi e variazioni di CO2, scimmiottando molto dettagliatamente, dal punto di vista metodologico, l’analisi di Charney sull’ “Equilibrium Sensitivity” della temperatura ad un raddoppio della CO2[9].

Ad ogni modo, non si può negare che il metodo applicato da Charney fosse completamente innovativo: nessuno prima aveva provato a predire i cambiamenti del clima utilizzando complicati modelli dinamici ove si parametrizzano alcune variabili conosciute e altre stimate. I lavori di Charney hanno influenzato anche Edward Lorenz, pioniere della “chaos theory”, ovvero quella branca della matematica per cui si teorizza che un cambiamento minimo in uno stato iniziale di un sistema possa portare a grandi differenze in uno stato successivo: come il proverbiale battito d’ali di una farfalla in Cina che può portare alla formazione di un uragano in Texas.

Il paragone del battito d’ali della farfalla è particolarmente calzante al caso della CO2 nei modelli climatologici, dove risulta necessario assumere dinamiche caotiche per giustificare un nesso causale. La quantità di CO2 nella troposfera ammonta a uno 0,04%, mentre il principale gas serra, ovvero il vapore acqueo, può saturare l’aria fino al 4,24% e mediamente è presente per l’1%. Seppur in passato la terra abbia avuto livelli di CO2 altissimi (anche 15 volte quelli di oggi), nel corso degli ultimi millenni si stima che la quantità di CO2 non abbia mai superato le 300 parti per milione (0,03%), sempre che i carotaggi nei ghiacci ai poli siano un metodo affidabile di misurazione. Questo vorrebbe dire che dal XIX secolo ad oggi la CO2 sarebbe aumentata di un terzo, passando dallo 0,03% allo 0,04% dell’aria. È una crescita modesta se si pensa che la quantità di CO2 nell’aria assorbe calore secondo una funzione logaritmica, ovvero più cresce la quantità di CO2 e minore è l’impatto sulla temperatura[10].

Il calore sulla terra deriva prevalentemente dal Sole, ma un lievissimo aumento di CO2 farebbe aumentare in modo infinitesimale la temperatura. Secondo la teoria del riscaldamento antropogenico questo aumento, per quanto piccolo (il battito della farfalla), comporterebbe comunque una maggiore evaporazione dell’acqua dagli oceani, quindi il vapore acqueo trattiene ancora più calore sommandosi all’effetto della CO2, mentre i ghiacciai si sciolgono maggiormente, riducendo l’effetto albedo (poiché la luce solare non viene più riflessa, ma assorbita dalla terra) il che aumenta ancora di più la temperatura. E così via in modo ricorsivo: evapora ancora più acqua e si sciolgono ancora più ghiacci, amplificando sempre più gli effetti di un modesto cambiamento iniziale. È in questo modo che, secondo i teorici dell’AGW, la temperatura sarebbe aumentata di quasi mezzo grado in un secolo.

Assunzioni controverse a fondamento di una “soft science”

Questo tipo di applicazione della chaos theory richiede in genere una conoscenza estremamente elevata dei fattori inclusi nella funzione, in forte contrasto con quanto effettivamente sappiamo ad oggi relativamente al clima. Non riusciamo nemmeno a prevedere il momento in cui si verificano alcuni dei principali fenomeni climatici che si ritiene abbiano impatti sulla temperatura, perché non ne comprendiamo bene le cause o difettiamo nella misurazione dei fattori che le scatenerebbero, né siamo in grado di anticipare quale sarà l’intensità con cui si presenteranno: l’Oscillazione Multidecennale Atlantica (AMO), l’Oscillazione pacifica decadale (PDO), El Niño e il Niño indiano (IOD), le correnti oceaniche e la circolazione termoalina, l’attività vulcanica, i venti, l’attività solare, i cicli Milankovich e le inversioni dei poli, vapore acqueo e cicli dell’acqua[11] – relativamente a tutti questi fenomeni abbiamo solo ipotesi e stime, relativamente sia a cause che impatti sul clima.

La nostra scarsa conoscenza di questi fenomeni è solo una delle ragioni per cui ci è impossibile corroborare in senso scientifico l’ipotesi che il riscaldamento globale sia dovuto all’uomo facendo uso di modelli caotici, infatti:

- ci sono troppe variabili in input nei modelli che hanno dinamiche che non sono del tutto conosciute, eppure vengono parametrizzate e conteggiate in modo deterministico;

- non solo il coefficiente d’impatto sul clima di ogni fattore è stimato, ma spesso anche gli stessi valori che vengono attribuiti alle variabili sono incerti e calcolati tramite proxy;

- i problemi non riguardano solo gli input, ma anche l’output: per verificare la correttezza del modello, questo viene fatto combaciare a temperature realmente misurate soltanto in un arco temporale molto breve (gli ultimi decenni), mentre in qualsiasi altro periodo la temperatura usata come benchmark è soltanto un valore calcolato;

- I risultati dei modelli non sono mai correttamente predittivi.

Insomma, la climatologia ad oggi è una “soft science” in cui si può dire tutto e il contrario di tutto (un po’ come le teorie macroeconomiche moderne considerate “ortodosse”) e di cui persino la versione “ufficiale” continua a cambiare, anche sensibilmente, come constatiamo leggendo gli stessi report dell’IPCC.

Copertina del noto singolo di Albano e Romina edito da EMI nel 1982. Il testo: “E il tuo sguardo innocente in mezzo alla gente, la felicità / È la pioggia che scende dietro le tende, la felicità…”

Approfondendo bibliografia e fonti dai documenti dagli altri istituti citati, oltre allo U.S. Global Change Research Program (IPCC, ACIA etc.), notiamo che i riferimenti sono sempre ai medesimi modelli. Ad esempio l’Arctic Climate Impact Assessment (ACIA)[12] è molto dettagliato sulla situazione dell’Artico, ma quando si tratta di spiegare la relazione con il riscaldamento globale, rimanda alle dichiarazioni dell’IPCC e a modelli e ricerche non sviluppate internamente, fra cui i già citati CGCM ed ECHAM:

- CGCM2 Canadian Centre for Climate Modelling and Analysis (Canada)

- 4 National Center for Atmospheric Research (US)

- ECHAM4/OPYC3 Max Planck Instituto for Metereology (Germany)

- GFDL-R30_c Geophysical Fluid Dynamics Laboratory (US)

- HadCM3 Hadley Centre for Climate Prediction and Research, United Kingdom

La vasta letteratura “pro AGW” in realtà è semplicemente una gran quantità di revisioni e perfezionamenti di questi modelli (alcune centinaia di papers). Nella ricerca “Quantifying the consensus on anthropogenic global warming in the scientific literature” li troviamo per lo più nella sezione “methods”.

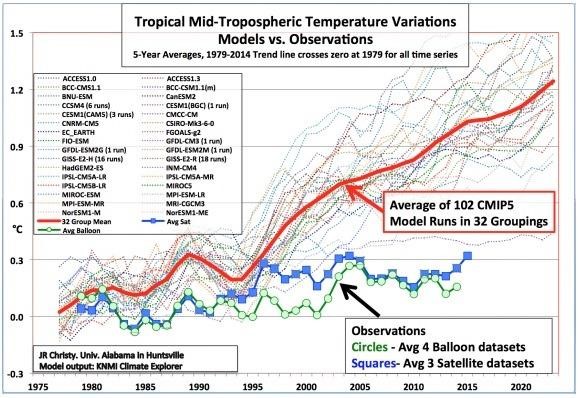

Ma quanto sono affidabili questi modelli? Una teoria scientifica è falsificabile (e quindi eventualmente ritenuta affidabile, dopo molte falsificazioni superate) quando risulta predittiva. Nel grafico riportato qui sotto, vediamo come si sono comportati 102 diversi modelli CMIP5 rispetto alle temperature effettivamente misurate[13]. Non solo questi modelli falliscono nel formulare proiezioni affidabili, ma anche l’elevata varianza fra di essi è indice di quanta incertezza ci sia sulla materia, essendoci fino a un grado Celsius di distanza fra i modelli presentati, che in un periodo così breve è un’enormità.

Anche l’IPCC nei suoi documenti ufficiali riconosce il fallimento delle proiezioni dei modelli:

“Quasi tutte le simulazioni storiche CMIP5 non riproducono la recente interruzione osservata nel riscaldamento globale”[14]

Stime volubili e mai verificate

A riprova dello scarso potere predittivo dei modelli, lo stesso IPCC ha dovuto rivedere più volte il coefficiente attribuito al ruolo della CO2 sulle temperature globali, che tecnicamente chiamiamo “climate sensitivity” o TCR. Nel 1990 il report dell’IPCC riportava le stime di Charney del 1979 per cui un un raddoppio della CO2 può portare ad un aumento delle temperature di circa 3 gradi (da 1.5 a 4.5)[15]. Nel 2007 le stime sono aumentate fino ad un range da 2 a 4.5 gradi (con le teorie di Foster, Annana, Schmidt e Mann). Nei report successivi però, in seguito alle più recenti teorie di Berntsen, Hargreaves o Lewis, e anche per via della scarsa performance dei modelli CMIP5[16], le nuove stime dell’IPCC riducono notevolmente la climate sensitivity, ad un range da 1 a 3 gradi.

Anche il grado di certezza con cui è supportata ogni ipotesi è variato molto negli anni. Il report del 1990 trattava la stima di Charney ancora come una mera ipotesi. Come cita lo stesso Fourth National Climate Assessment, nel primo IPCC si concludeva che gli effetti dell’influenza umana sul clima non erano affatto una certezza:

“Il primo report dell’IPCC concludeva che un’influenza umana sul clima non è stata ancora scoperta:

«per almeno un decennio, è improbabile che si provi in modo inequivocabile, sulla base delle osservazioni, che vi sia un effetto dei gas serra sulla temperatura»”[17]

Tuttavia, già nel 1996 l’IPCC parlava di “evidenza”, rafforzando tale posizione nel 2001. La teoria AGW è stata promossa sempre di più nel corso dei due IPCC successivi, in una sorta di escalation. Apparentemente, le convinzioni espresse dall’IPCC si sono progressivamente consolidate intorno alla stima di Charney, pur lasciandola invariata per quasi 30 anni! Infatti la climate sensitivity di Charney del 1979 è rimasta la stima riportata dall’IPCC fino al report del 2007. Oggi, l’IPCC stesso riconosce l’aleatorietà di queste stime, dovute da un lato all’incertezza nei dati osservati, dall’altro lato agli errori nella parametrizzazione dei processi del clima in modelli matematici caotici[18]:

“Incertezza nei dati osservati:

In certi casi, l’insufficiente estensione o qualità dei dati osservati rende la valutazione del modello impegnativa, ed è un problema frequente nella valutazione dei trend o dei cambiamenti climatici simulati”.

box 9.3 pp. 810

“Incertezza nella rappresentazione dei processi:

Alcuni errori possono essere dovuti all’incertezza nella rappresentazione (parametrizzazione) dei processi. Sono problemi comuni nei modelli climatici, che riflettono la nostra limitata, sebbene gradualmente crescente, comprensione dei processi molto complessi e delle sfida intrinseche alla loro rappresentazione matematica”

“Ogni bit di complessità aggiunta […] introduce nuove fonti di possibili errori (es. tramite parametri incerti) e nuove interazioni fra le componenti dei modelli possono, anche se solo temporaneamente, deteriorare il modello […] nonostante i progressi fatti, rimane incertezza scientifica riguardante i dettagli di molti processi”.

FAQ 9.1 pp. 824

Poiché i modelli CIMP non erano coerenti e le proiezioni sbagliate, si sono introdotti diversi parametri di misura al fine di migliorarli: l’ECS (Equilibrium Climate Sensitivity) o l’ESS (Earth System Sensitivity). Questi rappresentano perfetti esempi di “bit di complessità aggiunta” che rendono esponenzialmente più complicati ed incontrollabili i modelli. L’ECS tiene conto del tempo impiegato dal riscaldamento derivato da CO2 per essere assorbito dagli oceani, finché la terra raggiunge un nuovo equilibrio; l’ESS include nei calcoli quei cambiamenti ricorsivi della temperatura dovuti all’impatto di variazioni precedenti su vari fattori, fra cui addirittura la vegetazione! Qualsiasi ricercatore che abbia sufficienti basi metodologiche in teorie quantitative, dagli economisti ai fisici, matematici o statistici, può rendersi conto della scarsa significanza dei risultati di questi modelli climatici e, in definitiva, della mancanza di scientificità sottostante non solo alla teoria AGW, ma addirittura ad intere aree di studio della moderna climatologia![19].

Variabili e parametri inaffidabili

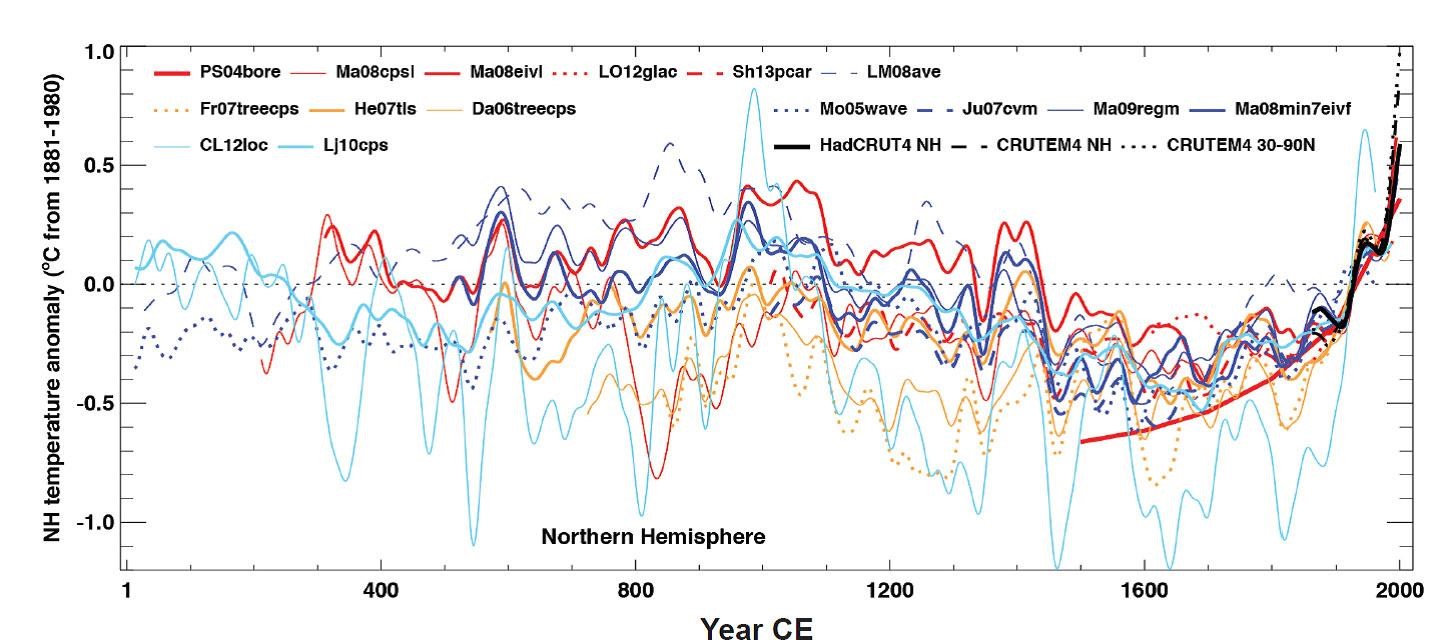

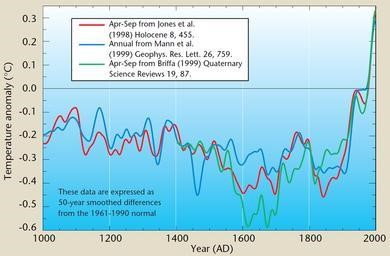

Non solo le interazioni fra le variabili all’interno dei modelli sono del tutto ipotetiche, ma anche le ricostruzioni stesse della temperatura hanno un’enorme variabilità e incertezza. Nel grafico di seguito (fonte IPCC) si può vedere come le ricostruzioni varino da un modello all’altro addirittura di 1 grado e mezzo. Abbiamo una buona quantità di rilevazioni dirette affidabili soltanto dal secolo scorso, per il resto dobbiamo affidarci a studi sui pollini, coralli, sedimenti sui letti dei fiumi, carotaggi nel ghiaccio e anelli degli alberi.

download qui il report IPCC in pdf

Molte di queste ricostruzioni riportano temperature passate sempre più basse rispetto a quelle attuali, lasciando supporre che il periodo in cui viviamo è il più caldo degli ultimi millenni, mentre al contrario, altre ricostruzioni rispecchiano più da vicino le teorie sul “periodo caldo romano e medievale”, di cui abbiamo anche parecchie testimonianze scritte, archeologiche e paleobotaniche: Teofrasto parla di alberi di datteri in Grecia, Annibale passava le Alpi con gli elefanti in Italia, ma soprattutto vi è evidenza della produzione di circa 10 mila litri di vino all’anno in Northamtonshire, Inghilterra, su circa 30 acri di terreno (oltre che a Cambridgeshire, Lincolnshire e Bukinghamshire), dove peraltro è documentato che venivano seguite le stesse tecniche di produzione che i Romani utilizzavano nel mediterraneo. Insomma è molto probabile che mille o duemila anni fa le temperature fossero pari o superiori ad oggi.

Antica pittura rupestre ritraente una nota esponente del Climarxismo, impegnata a predire il funesto futuro degli uomini malvagi che cercano il profitto

Fidarsi delle ricostruzioni fatte dai climatologi sulla temperatura può non essere sempre una buona idea. Un esempio eclatante è quello degli anelli degli alberi come proxy. Secondo la teoria, l’anello di un albero sarà più largo quanto maggiore è la temperatura, di conseguenza la temperatura stimata per ogni anno di vita dell’albero segue proporzionalmente la dimensione dell’anello. Avendo a disposizione alberi millenari (alcuni ancora in vita) possiamo ricostruire temperature risalenti fino a 13.000 anni fa[20]. Tuttavia sappiamo, anche solo per buon senso, che lo spessore degli anelli di un albero dipende da molte altre variabili (sole e nuvolosità, umidità e piogge, altra vegetazione che concorre al consumo delle risorse del suolo, presenza di parassiti o animali che intaccano le radici etc). Secondo alcune teorie[21] poi, gli alberi molto vecchi (che ovviamente sono gli unici a poterci dare informazioni su periodi antichi) possono soffrire di un rilassamento delle fibre con l’età e quindi dare l’impressione di crescere di più; oppure ancora, si pensa che la CO2 in aumento negli ultimi anni possa direttamente aver fatto crescere di più gli alberi, e non quindi la temperatura.

Insomma, senza conoscere assolutamente nulla delle altre variabili, la validità degli anelli degli alberi come proxy per calcolare le temperature perde di credibilità. Di fatto, è ben noto il così detto “divergence problem”[22], per cui se guardiamo alla vegetazione, dagli anni ’50 ad oggi sembrerebbe che non ci sia stato alcun aumento di temperatura… contrariamente a quello che dice il termometro!

Affermare che alcune ricostruzioni possano essere distorte da un’ideologia di fondo non è una tesi complottista, ma è una semplice constatazione di “public choice theory” basata su molti fatti oggettivi, come a esempio il caso Climategate, di cui parleremo a breve. Al di là del caso specifico, spesso i catastrofisti concentrano la loro attenzione su elementi accidentali senza guardare ad un contesto più ampio. Due esempi su tutti: è vero che i ghiacci del polo nord siano ai loro minimi storici da quando li misuriamo, come è anche vero che i ghiacci del polo sud siano ai loro massimi storici da quando li misuriamo. Eppure quest’ultimo dettaglio è spesso trascurato da chi fa “sensazionalismo”. Per non parlare del baccano mediatico dietro a vicende recenti come l’ultimo allagamento di Venezia, quando abbiamo oltre 70 episodi straordinari passati alle cronache sin dal 782 d.C[23]. E per chi dubitasse delle testimonianze storiche, abbiamo persino i dipinti, come quello di Vincenzo Chilone, sull’acqua alta del dicembre 1825 (“acqua alta” è espressione originariamente del dialetto veneziano, poi mutuata dall’italiano).

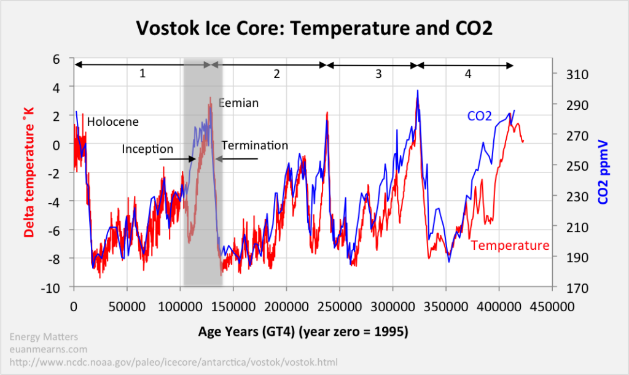

Il sensazionalismo è spesso promosso da istanze pseudo-scientifiche, come il seguente grafico, che nelle intenzioni dovrebbe farci presumere ci sia un’elevata correlazione fra CO2 e temperatura.

Una correlazione tanto perfetta in un sistema caotico è molto sospetta. Anzitutto, abbiamo visto quanto siano incerte le stime persino degli ultimi 2000 anni e quanto è grande la variabilità se si considerano diversi proxy, il che ci fa pensare che, trattandosi di un grafico che spazia su un periodo di centinaia di migliaia di anni, il grado di confidenza sia estremamente basso. Soprattutto però, il grafico mostra che prima è la temperatura a scendere, e soltanto dopo segue la CO2, con uno scarto da 800 a qualche migliaio di anni (il grafico è “girato”[24]: il presente è l’anno zero, a sinistra, mentre l’estremo a destra 450 mila anni fa). Questo suggerisce tre cose:

- La relazione di causa-effetto potrebbe essere invertita (la temperatura influisce sulla CO2 anziché viceversa), oppure la correlazione potrebbe essere spuria ed esiste un fattore terzo che causa discese e salite sia di CO2 che di temperatura (es. attività vulcanica, o altro)

- Se i dati riportati fossero corretti, sarebbe comunque illogico proiettarli sulla situazione climatica attuale. Infatti, anche assumendo come vero il rapporto causale fra le due variabili, gli effetti si avrebbero soltanto dopo alcune centinaia di anni e non certo in qualche decennio o un secolo

- Nel grafico il range di temperature spazia su quasi 12 gradi, a fronte di un aumento massimo di CO2 del 50% (da circa 200 a 300 parti per milione). Se la climate sensitivity dovuta alla CO2 fosse così elevata, fra qualche secolo la Terra finirebbe per avere il clima di Venere, a causa dell’uomo. Tale ipotesi sarebbe anche smentita da altre ricostruzioni che mostrano come in passato i livelli di CO2 fossero molto più alti di oggi.

Il caso Climategate: assessment scientifici o di convenienza politica?

Raro scatto che cattura Greta Thunberg in compagnia dell’ebreo kattivo dell’establishment che la manipola, cavalcandola come un gigante di Attack on Titans.

Nonostante la scarsa affidabilità di alcuni proxy usati per ricostruire le temperature, alcuni climatologi non sembrano farsi alcuno scrupolo a manipolare informazioni per scopi politici. Uno degli scandali del caso Climategate riguarda proprio la mistificazione dei dati sfruttando le serie storiche sulla crescita degli alberi per ricostruire le temperature, come vedremo a breve.

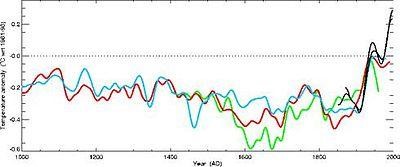

Nel 2009 Wikileaks rivela gli scambi di mail della Climate Research Unit (CRU) e fra i protagonisti dello scandalo vi sono alcuni esponenti di spicco nel mondo della climatologia che hanno scritto e redatto alcuni capitoli importanti dei rapporti dell’IPCC. Phil Jones è a capo del CRU e insieme a Michael Mann ha scritto il 12° capitolo del terzo rapporto IPCC (2001): “identificazione dei cambiamenti climatici e attribuzione delle cause”, oltre che altri articoli noti. Michael Mann, a sua volta è il famoso climatologo ideatore del grafico “hockey stick” pubblicato su Nature e incluso nel report dell’IPCC del 1999, dove si mostra un’impennata verso l’alto delle temperature negli ultimi decenni.

Ebbene, Phil Jones stava preparando un grafico per la cover dello statement del 1999 del World Meteorological Organization (WMO), quando scrisse la seguente mail a Mann e altri ricercatori:

“Ho appena completato il trucco di Mann [fatto sull’articolo di] Nature di aggiungere le temperature reali ad ogni serie storica […] per nascondere il declino [delle temperature ricostruite tramite proxy][25].

Infatti, il grafico che comparirà è il seguente, dove si vede un’impennata di tutte le linee nell’ultimo secolo, compresa la linea verde (che rappresenterebbe la temperatura ricostruita utilizzando il proxy degli anelli degli alberi):

Il grafico senza “manomissioni” invece sarebbe dovuto risultare come quello riportato di seguito: soltanto la temperatura realmente misurata (in nero) ha un’impennata, ma di questo dato abbiamo misurazioni solo recenti. Le temperature ricostruite invece non seguono affatto quelle realmente misurate e non riportano affatto quell’impennata.

Poiché non c’è corrispondenza fra le temperature reali e i proxy nel periodo storico in cui possiamo misurarli entrambi (nell’ultimo secolo), allora non possiamo assumere che in tutto il periodo storico che compare nel grafico le temperature reali seguissero davvero quelle stimate/ricostruite tramite i proxy. Phil Jones invece, interrompendo la serie storica ricostruita al 1950 e continuando, dopo quella data, le stesse linee con le temperature reali, distorce completamente la percezione di quello che può essere realmente accaduto nella storia del clima (la linea verde nel primo grafico viene fatta coincidere con quella nera, nascondendo così la fase calante dopo il 1950).

Questo è uno dei tantissimi esempi di “malafede” di alcuni degli “scienziati” che hanno partecipato ai report dell’IPCC. Non è il caso di fare qui un resoconto completo, poiché i documenti Climategate contano oltre mille e-mail (si possono leggere spiegati e redatti qui[26]), ma per una breve infarinatura:

- Pare che Phil Jones fosse l’unico custode di alcuni dei dati grezzi del CRU su cui si sono basati alcuni documenti dell’IPCC e che non sono mai stati rinvenuti, e anzi sarebbero stati “inavvertitamente cancellati” nell’ultimo cambio di sede dell’organizzazione, come ammesso dal CRU

- In varie mail del 2005 Phil Jones dimostra di essere terrorizzato per un Freedom of Information Act, e afferma che piuttosto che mandare i file a qualcuno, li distruggerebbe.

- Jones, che afferma di aver cancellato di proposito una gran quantità di email, chiede a Mann di cancellare alcune conversazioni che si sono scambiati, oltre ad ogni scambio via email con altri climatologi (Keith e Gene) e dice a Mann di chiedere a Keith di fare lo stesso. Mann risponde che contatterà Gene il più presto possibile. In altre mail Jones chiede a Mann, Bradley, Hughes e Ammann nell’ordine: di cancellare mail, di non menzionare a nessuno che nel Regno Unito c’è la possibilità di un Freedom of Information Act, di tenere riservatezza sulle loro comunicazioni e cancellare gli allegati.

- Filippo Giorgi, co-autore del capitolo 10 dell’IPCC, scriveva a tutti i colleghi di trovarsi a disagio col fatto che chiunque altro nel gruppo di autori sembrasse accettare criteri di scientificità così laschi, per cui praticamente qualsiasi cosa è fatto passare per un assessment scientifico[27]

- Si tenga in considerazione che dichiarazioni sensazionalistiche potevano tornare molto utili al Climate Research Unit, dato che Phil Jones ha “raccolto” per il CRU finanziamenti per 13,7 milioni di sterline dal governo britannico e il comitato intergovernativo che ha redatto l’IPCC ha vinto nel 2007, insieme ad Al Gore, il premio Nobel per la pace.

- L’indirizzo “politico” e il “bias” dei ricercatori traspare molto bene dagli scambi di comunicazioni fra vari scienziati nelle mail rivelate. Un esempio su tutti, lo scambio tra Keith Briffa e Gary Fankhouser. Il primo invia dei dati al secondo, chiedendogli di tirare fuori qualcosa di sensazionalistico che possa colpire le masse ignoranti, poiché è quello che lui e il board dell’IPCC vogliono vedere. Il che mostra quanto alcuni esponenti dell’IPCC tentassero di pilotare dall’alto quanto presentato nei report:

“A me e al board piacerebbe vedere le più larghe implicazioni di queste statistiche chiaramente esposti e largamente comprensibile dalle masse ignoranti”[28]

Fankhouser, due giorni dopo, risponde spiegando come abbia cercato in tutti i modi di trovare dai dati qualcosa di sensazionalistico e che non sia il caso di spingere oltre:

“Ho provato ad applicare ogni trucco del mestiere [“trick out of my sleeve”] per spremere qualcosa fuori da quei dati […] Penso che dovrei lasciarli così come sono”[29]

Niente di più lontano dalla deontologia professionale che dovrebbe mantenere ogni scienziato.

- Willie Soon and Sallie Baliunas ottennero che il loro paper “scettico” in merito all’AGW fosse pubblicato sulla rivista Climate Research. Il paper esaminava 240 articoli precedentemente pubblicati guardando ad anomalie della temperatura nel periodo caldo medievale e la piccola era glaciale (XIV-XIX secolo), concludendo che probabilmente quello di oggi non è affatto il periodo più caldo degli ultimi mille anni, sottolineando così il loro disaccordo con gli studi sull’Hockey stick di Mann, Bradley e Hughes. Nelle email rivelate da Wikileaks, Phil Jones dice che farà pressioni affinché la rivista si sbarazzi di quell’ “editore problematico”[30] che ha pubblicato la ricerca di Soon e Baliunas (Chris De Freitas). Michael Mann replica: “Credo dovremmo smettere di considerarla una rivista legittima, incoraggiando i nostri colleghi della comunità scientifica a non proporre più articoli e a smettere di citarla nei loro lavori”.

Jones e Mann crearono un polverone politico-mediatico enorme: sono state fatte pressioni agli editori Hans von Storch and Clare Goodess, che hanno sollevato la questione direttamente a De Freitas e al publisher della rivista Otto Kinne. De Freitas non si è piegato, parlando di caccia alle streghe e Santa Inquisizione e Otto Kinne lo ha supportato, dicendo che il paper di Soon e Baliunas è stato condiviso e valutato molto attentamente da diversi ricercatori prima di essere pubblicato, perciò De Freitas aveva fatto bene il suo lavoro[31]. Ciononostante, il caporedattore Hans von Storch (insieme ad altri scienziati) si è dimesso dal comitato editoriale della rivista Climate Research. Soon e Baliunas invece, insieme ad altri autori, hanno dato convintamente seguito alla loro tesi, approfondita in papers successivi.

Modelli econometrici, dietologia e altre “soft science” per politicanti

in foto, il tipico imprenditore italiano che per fare business è costretto a nascondersi nelle fogne, ma una nuova ideologia di distruzione lo perseguita…

La climatologia ricorda da vicino quei modelli econometrici degli economisti che non hanno mai saputo prevedere i cicli economici, men che meno le crisi finanziarie (Grande depressione ’29, lunedì nero ‘87, crisi del 2008), eppure sono eletti a teorie consolidate nel mondo mainstream accademico e politico. Sono modelli complessi che relazionano molte variabili economiche, ma spesso poggiano su postulati di partenza che sono teorie sbagliate e mai predittive, formulate sulla base di pochi capisaldi, come la General Theory di Keynes e i modelli IS-LM di Hick, o le regole di politiche monetaria di Fisher in passato, di Taylor oggi.

La ciclopica quantità di papers, articoli e pagine scritte su complessi modelli econometrici che sono sbagliati è un vezzo che non si permettono solo le università di economia. C’è qualcosa che accomuna la macroeconomia, la climatologia o la nutrizione, ovvero la complessità dell’organismo studiato, dove ogni parametro misurabile può essere influenzato, e influenza a sua volta, molti altri parametri, in un complicato sistema di feedbacks. Ci sono teorie nei più disparati campi del sapere che si sono rivelate un enorme inganno, a cui hanno abboccato in tutto il mondo le più importanti istituzioni. Non è più il regno della scienza, ma della politica e delle dottrine pseudo-religiose.

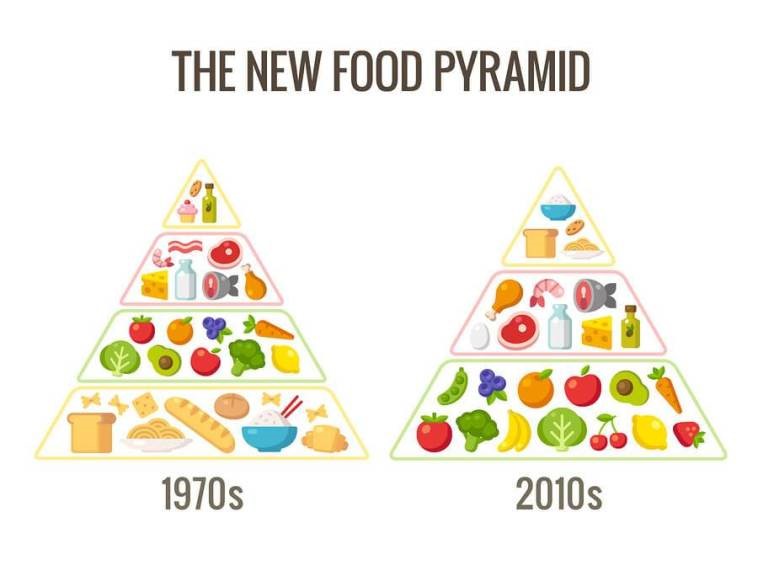

Pensiamo alla dietistica e nutrizione: la piramide alimentare promossa dal dipartimento dell’agricoltura e del dipartimento della salute americano (“The food guide pyramid”, 1992) è stata per anni sponsorizzata in tutto il mondo, compresi i libri scolastici italiani, come il modello di dieta ideale, mentre oggi è surclassato da praticamente tutte le teorie moderne, sia mainstream che eterodosse (es. la paleo dieta) e le istituzioni politiche sono passate ad una seconda versione della piramide alimentare.

La piramide alimentare: per oltre trent’anni ci hanno raccontato una barzelletta spacciandola per scienza: istituzioni, libri di testo, dietologi di tutto il mondo. Era caccia alle streghe per chi la pensava diversamente, ma 40 anni dopo è stata completamente ribaltata: la base è ora al vertice

Sistemi complessi come il clima o l’economia, che non riusciamo a capire a fondo, non sono regolabili tramite interventi che, a loro volta, producono conseguenze complesse e imprevedibili (soprattutto nel lungo periodo), quale può essere ad esempio una tassa su un certo tipo di produzione o di consumo. Semmai, possiamo utilizzare scorciatoie euristiche per approcciarci a un problema, usando buon senso e guardando a quanto ci insegna la storia. Ad esempio, sappiamo che l’intervento coercitivo dello Stato sull’economia (in generale, qualsiasi atto di violenza e imposizione sulla volontà degli individui) non è utile né all’economia, né alla cultura, né all’ambiente.

La politica non è mai motivata da istanze scientifiche, né il braccio armato e violento della politica darà mai atto in modo razionale e scientifico alle sue delibere. Tassarci per combattere il cambiamento climatico è ingenuo per una serie di ragioni:

- È quasi sempre inefficace se guardiamo agli effetti, talvolta persino controproducente e finisce per avere esiti opposti

- Una tassa è sempre dis-ecologica, perché comporta necessariamente inefficienze, sotto molti punti di vista, mai contemplati dal pianificatore centrale. L’inefficienza è uno spreco energetico e – quindi – necessariamente inquinamento. Ma qui l’analisi si fa sottile e dovremmo aprire un capitolo a parte per approfondire i principi economici dietro queste affermazioni

- Il libero mercato porta ricchezza ed innovazione tecnologica: entrambe sono lo strumento più utile che abbiamo per darci i mezzi per la preservazione dell’ambiente, sempre che sia nostra intenzione preservarlo allo stato attuale

Il grande pianificatore centrale

Nel 1958 Mao Tse-Tung mise in atto il piano quinquennale chiamato il “Grande balzo in avanti“, che si rivelò un disastro economico. Fra gli obiettivi del piano, vi era anche la “lotta ai quattro flagelli” per sterminare zanzare, mosche, ratti e passeri. Questi ultimi erano ritenuti colpevoli di mangiare grandi quantità di grano dai campi, sottraendolo al popolo cinese. Il popolo fu mobilitato contro i passeri: nidi furono divelti, uova distrutte, pulcini uccisi. Si stima che furono abbattuti otto o dieci milioni di uccelli.

Presto i dirigenti comunisti si resero conto che i passeri non mangiavano solo grano, ma anche una moltitudine di insetti nocivi per i raccolti, così iniziarono ad importare passeri dall’URSS. Ma era troppo tardi: la popolazione di cavallette e altri insetti, in assenza del loro predatore naturale, aumentò considerevolmente. Quell’anno si stima che siano morti di fame fino a 43 milioni di cinesi. Questo è quello che può accadere quando un governo tenta di imporre un cambiamento dell’ecosistema, per il bene di tutti.

Ex-post questa storia può sembrare assurda, ma la differenza con le politiche che subiamo oggi vede qualche variazione di grado, non certo di tipo. Siamo sottoposti alle stesse nefandezze e le accettiamo pure di buon grado, talvolta con entusiasmo, riempiendo le piazze di manifestanti ipocriti e benpensanti, che non hanno capito proprio niente né di inquinamento né di cosa si può fare per rendere migliore il mondo in cui viviamo.

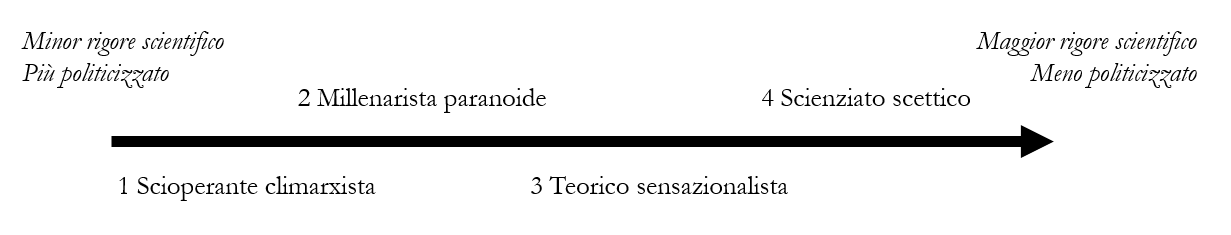

Se prendiamo come estremo, da un lato, le dichiarazioni allarmistiche lanciate nelle manifestazioni di strada dagli “scioperanti climatici” (spesso ripetute da stampa generalista e politica) e all’altro estremo, le ipotesi di cambiamento climatico formulate e testate secondo il metodo scientifico propriamente detto, otteniamo un “continuum” estremamente eterogeneo, molto difficile da trattare globalmente senza fare le dovute distinzioni. Ogni categorizzazione comporta necessariamente delle semplificazioni, ma possiamo comunque distinguere le posizioni più comuni in merito al cambiamento climatico in quattro principali macro-gruppi collocati su tale continuum, la cui caratteristica più evidente è che, passando da un estremo all’altro, aumenta il rigore scientifico delle affermazioni, ma diminuisce al contempo la pretesa portata politica.

- Il primo gruppo di affermazioni supporta precise politiche orientate nella direzione di maggiore pianificazione, regolamentazione, tassazione, interventismo, dirigismo, centralismo, proibizionismo, collettivismo e addirittura di “lotta al capitalismo” – come si legge in molti manifesti e slogan – che sarebbero risolutive relativamente ad un’apocalisse climatica provocata dall’attività umana. Tali affermazioni paiono assolutamente in contrasto diretto con l’evidenza non solo scientifica, ma anche storica, economica e logica. Bisogna anche notare che queste posizioni sono più popolari nei paesi ove vi è relativamente minore produzione di CO2, per cui l’estensione di un intervento politico interno è giocoforza limitata. Inoltre, nel paradossale contesto di una civiltà umana tanto potente da alterare il clima mondiale, è assurdo che non si faccia mai menzione ad alternative di tipo tecnologico e imprenditoriale.

- Vi sono poi le affermazioni per cui, a prescindere dalle possibili soluzioni a un’imminente crisi, il clima globale stia cambiando in modo da provocare una catastrofe imminente, con un costo di miliardi di vite umane, possibilmente fino all’“estinzione”. Queste posizioni sono attualmente più vicine a speculazioni da romanzo di fantascienza, e come tali magari interessanti dal punto di vista filosofico o pregevoli dal punto di vista narrativo, ma certamente non fondate su evidenze scientifiche di sorta, in quanto richiedono ipotesi particolarmente fantasiose al fine di trasformare fenomeni noti di tipo “sub-lineare” (come l’effetto serra) in fenomeni ignoti di tipo “super-lineare” (con impatti anche esponenziali). Queste posizioni inoltre, mancano di coerenza logica anche perché non spiegano il motivo per cui un aumento globale di temperature dovrebbe portare ad un peggioramento globale della situazione, anziché ad un suo miglioramento, considerato che viviamo su un pianeta in cui la massa di terre emerse troppo fredde per essere compatibili con la vita umana supera di molto la massa delle terre emerse troppo calde per essere compatibili con la vita umana.

- Procedendo nel continuum, troviamo quindi quelle affermazioni sensazionalistiche per cui, a prescindere dagli effetti catastrofici e apocalittici di tale cambiamento, il clima globale stia oggi cambiando in modo anomalo dal punto di vista geologico e sotto la spinta causale diretta dell’emissione di biossido di carbonio collegata alle attività industriali umane. Queste posizioni sembrano al momento basate su alcune ipotesi ancora altamente speculative (in quanto tali sicuramente rispettabili), attualmente prive di qualunque modello predittivo che possa dirsi corroborato da anni di tentativi di falsificazione, o da qualunque metodologia di riproducibilità controllata che possa trasformare indizi di correlazione in evidenze di causalità. Questo al netto di una forte amplificazione mediatica che ha motivazioni sociologiche e politiche, che spiegano anche alcuni casi storicamente comprovati di manipolazione, truffa, esagerazione e rappresentazione fuorviante dei fatti (come nel caso Climategate).

- Infine, ci sono quelle affermazioni per cui il clima complessivo del nostro pianeta stia ancora, oggi come in passato, attraversando processi importanti di cambiamento, nella direzione peraltro di un lieve aumento medio delle temperature nel corso degli ultimi decenni, in conseguenza di diverse dinamiche che sembrano anche includere (seppure non limitandosi ad esso) l’effetto schermante dei cosiddetti “gas serra” – fra cui è inclusa, in misura molto limitata, anche la quota di CO2 liberata dall’attività umana. Tali affermazioni appaiono oggi realistiche e corroborate da dati riproducibili.

Nel dibattito odierno purtroppo si tende spesso ad utilizzare il “trucco retorico” di appiattire le differenze tra affermazioni tanto diverse, identificando, con un tipico “straw-man argument”, qualunque scetticismo rispetto alle prime tre posizioni con una sorta di “negazionismo” rispetto alla quarta categoria di affermazioni.

[1] “There is no convincing scientific evidence that human release of carbon dioxide, methane, or other greenhouse gases is causing or will, in the foreseeable future, cause catastrophic heating of the Earth’s atmosphere and disruption of the Earth’s climate”.

[2] http://www.petitionproject.org/gw_article/GWReview_OISM150.pdf

[3] https://clintel.nl/wp-content/uploads/2019/09/ecd-press-briefing.pdf

[4] https://clintel.nl/prominent-scientists-warn-un-secretary-general-guterres/

[5] proiezione sul totale dei papers sulla base delle percentuali sul nostro campione

[6] https://science2017.globalchange.gov/chapter/executive-summary/

[7] si legga ad es. Mike Jonas, 2015 https://wattsupwiththat.com/2015/09/17/how-reliable-are-the-climate-models/

[8]https://www.researchgate.net/publication/324840395

VALIDITY_AND_RELIABILITY_OF_THE_CHARNEY_CLIMATE_SENSITIVITY_FUNCTION

[9] https://wattsupwiththat.com/2018/04/20/the-charney-sensitivity-of-homicides-to-atmospheric-co2-a-parody/

[10] Lindzen and Choi, Nick Lutsko, and report of Steve Sherwood for Skeptical Science

http://nicklutsko.github.io/blog/2018/08/26/Why-CO2-Forcing-Is-Logarithmic

http://joannenova.com.au/2010/02/4-carbon-dioxide-is-already-absorbing-almost-all-it-can/

https://skepticalscience.com/why-global-warming-can-accelerate.html

[11] Per quanto riguarda il vapore acqueo, l’equazione Clausius-Clapeyron parla del 7% per 1 grado di temperatura atmosferica, ma non conosciamo gli effetti su altri fattori come le nuvole o i cicli dell’acqua

[12] https://www.amap.no/documents/doc/arctic-arctic-climate-impact-assessment/796

[13] Nota: ad oggi si possono contare circa 143 studi e paper sui modelli CMIP5 https://docs.google.com/spreadsheets/d/1Bw2XU3FCw9a__Z5Y9YGfCWU-ohzuhFJ8_gcGyIsTECE/edit#gid=0

[14] “Almost all CMIP5 historical simulations do not reproduce the observed recent warming hiatus” (capitolo 9 IPCC 2018/02 pp. 772)

[15] “We estimate the most probable global warming for a doubling of CO2 to be near 3°C with a probable error of ± 1.5°C.”

[16] Come hanno performato i modelli climatici:

Analysis: How well have climate models projected global warming?

[17] “The first IPCC report concluded that a human influence on climate had not yet been detected, but judged that «the unequivocal detection of the enhanced greenhouse effect from observations is not likely for a decade or more»” (IPCC, 1990: Climate Change: The IPCC Scientific Assessment. Cambridge University Press, pp. 212)

[18] https://www.ipcc.ch/site/assets/uploads/2018/02/WG1AR5_Chapter09_FINAL.pdf

“In climate research and modelling, we should recognise that we are dealing with a coupled non-linear chaotic system, and therefore that long-term predictions of future climate states is not possible”

“Uncertainty in Observational Data:

In some cases, insufficient length or quality of observational data makes model evaluation challenging, and is a frequent problem in the evaluation of simulated variability or trends”

“Uncertainty in Process Representation

Some model errors can be traced to uncertainty in representation of processes (parameterizations). Some of these are long-standing issues in climate modelling, reflecting our limited, though gradually increasing, understanding of very complex processes and the inherent challenges in mathematically representing them.”

“Climate models of today are, in principle, better than their predecessors. However, every bit of added complexity, while intended to improve some aspect of simulated climate, also introduces new sources of possible error (e.g., via uncertain parameters) and new interactions between model components that may, if only temporarily, degrade a model’s simulation of other aspects of the climate system. Furthermore, despite the progress that has been made, scientific uncertainty regarding the details of many processes remains.”

[19] Secondo Jamal Munshi, professore emerito alla Sonoma State University (California), la moderna climatologia proposta dall’IPCC non ha criteri di falsificabilità: “l’ampio spettro dei valori teorici proposti dall’IPCC (1.5-4.5 gradi) combinati con un’insufficiente disciplina statistica ha portato la maggior parte di ricercatori a ritenere che qualsiasi valore positivo di Climate Sensitivity (alla CO2) costituisca una conferma empirica alla teoria (AGW)”. L’accusa è gravissima, poiché se una teoria non è falsificabile, non è scienza, è solo una “large and undisciplined fishing expedition”, ovvero una “grande e indisciplinata battuta di pesca” (“fishing expedition” si può tradurre anche come “caccia all’informazione”).

[20] https://en.wikipedia.org/wiki/Dendrochronology

[21] http://www.climatedata.info/proxies/tree-rings/

[22] https://en.wikipedia.org/wiki/Divergence_problem

[23] https://it.wikipedia.org/wiki/Acqua_alta#Eventi_storici

[24]http://www.jerome-chappellaz.com/files/publications/climate-and-atmospheric-history-of-the-past-420-000-years-from-the-vostok-ice-core-antarctica-38.pdf

[25] “I’ve just completed Mike’s Nature trick of adding in the real temperatures to each series for the last 20 years (i.e. from 1981 onwards) and from 1961 for Keith’s to hide the decline”.

[26] http://www.lavoisier.com.au/articles/greenhouse-science/climate-change/climategate-emails.pdf

[27] “I feel that at this point there are very little rules and almost anything goes. I think this will set a dangerous precedent which might undermine the IPCC’s credibility, and I am a bit uncomfortable that now nearly everybody seems to think that it is just OK to do this.”

[28] “I would have to see it and the board would want the larger implications of the statistics clearly phrased in general and widely understandable (by the ignorant masses)”

[29] “I pulled every trick out of my sleeve trying to milk something out of that […] I think I’ll have to look for an option where I can let this little story go as it is”.

[30] “I will be emailing the journal to tell them I’m having nothing more to do with it until they rid themselves of this troublesome editor”

[31] https://en.wikipedia.org/wiki/Climatic_Research_Unit_documents